W dynamicznie zmieniającym się świecie controllingu finansowego, wydajność zapytań SQL staje się jednym z kluczowych czynników wpływających na jakość i czas reakcji na potrzeby zarządu. Raporty muszą być dostępne niemal natychmiastowo, a dane – precyzyjne i kompletne. Tu nie ma miejsca na opóźnienia. Właśnie dlatego zaawansowana optymalizacja SQL to coś więcej niż luksus – to konieczność.

Optymalizacja zapytań SQL polega na takim ich przekształceniu, aby wykonywały się szybciej i zużywały mniej zasobów, bez utraty poprawności. W controllingu, gdzie codziennie analizowane są ogromne wolumeny danych – od budżetów po analizy rentowności – nawet niewielka poprawa czasu wykonania zapytania może mieć realny wpływ na efektywność pracy całego działu.

W tym artykule krok po kroku pokażę Ci, jak rozpocząć proces optymalizacji od użycia narzędzia EXPLAIN, a następnie przejdziemy do stosowania indeksów oraz innych zaawansowanych technik. Jeśli pracujesz z bazami danych finansowych – ten przewodnik jest dla Ciebie.

Dlaczego optymalizacja SQL ma znaczenie w controllingu finansowym?

Controlling to serce analityki finansowej w każdej firmie. Podejmowanie decyzji opartych na danych wymaga nie tylko dostępności informacji, ale również ich szybkości i aktualności. Tutaj pojawia się SQL, czyli język, który pozwala na komunikację z bazą danych.

Problem? Gdy zapytania są źle napisane lub nieprzemyślane, zaczynają „dusić” system. Zamiast sekund – minuty. Zamiast odpowiedzi – timeouty. W skrajnych przypadkach – błędne wyniki, które mogą zafałszować cały obraz finansowy przedsiębiorstwa.

Optymalizacja SQL to więc nie tylko techniczne ulepszenie. To sposób na zabezpieczenie jakości informacji, które trafiają do analityków i menedżerów. Umożliwia sprawne działanie dashboardów BI, terminowe przygotowanie raportów miesięcznych, kwartalnych, rocznych. Bez niej – chaos, błędy, frustracja.

To trochę jak serwisowanie silnika w bolidzie Formuły 1 – nikt nie chce zmieniać opon w czasie wyścigu. Lepiej przygotować zapytania tak, by były szybkie, odporne i gotowe na duże obciążenia.

Praca z planem wykonania zapytania (EXPLAIN)

EXPLAIN to Twoje pierwsze i najważniejsze narzędzie diagnostyczne w świecie SQL. To jak rentgen dla zapytania. Kiedy uruchomisz komendę EXPLAIN przed zapytaniem SELECT, otrzymasz plan jego wykonania, czyli krok po kroku rozpisaną drogę, jaką baza danych przejdzie, by zwrócić wynik.

Plan pokazuje, które tabele będą skanowane, w jakiej kolejności będą łączone, czy zostaną użyte indeksy, jakie będą szacowane koszty operacji. W zależności od silnika bazy danych (np. PostgreSQL, MySQL, Oracle, SQL Server), EXPLAIN dostarcza nieco inne szczegóły, ale idea zawsze pozostaje ta sama – masz zrozumieć, co dzieje się „pod maską”.

To trochę jak mapa drogowa dla Twojego zapytania. Bez niej błądzisz po omacku. Dzięki niej wiesz, gdzie leży problem: pełne skanowanie tabeli? zły join? może brak indeksu?

Jak czytać plan wykonania zapytania?

Odczytywanie planu EXPLAIN to sztuka, ale do opanowania. Na pierwszy rzut oka może wydawać się skomplikowany, pełen terminów jak „Seq Scan”, „Nested Loop”, „Hash Join”, ale spokojnie – każdy z tych terminów to tylko wskazówka.

Na co zwracać uwagę?

- Typ operacji skanowania – np. „Seq Scan” oznacza, że tabela jest czytana w całości, co bywa bardzo kosztowne.

- Korzystanie z indeksów – „Index Scan” to znak, że zapytanie wykorzystuje indeks – dobry znak.

- Koszty operacji – w PostgreSQL dostajemy np. „cost=0.00..431.00”, co oznacza przewidywane zasoby potrzebne do wykonania operacji.

- Liczba wierszy – pozwala zobaczyć, ile rekordów system spodziewa się przetworzyć na każdym etapie.

- Filtry i warunki – informacja, gdzie stosowane są filtry i które kolumny są porównywane.

Zrozumienie tych elementów pozwoli Ci lepiej interpretować, co należy poprawić.

Najczęstsze problemy wykrywane przez EXPLAIN

Full table scan

To jeden z największych „zabójców wydajności”. Gdy system nie może znaleźć indeksu, który odpowiada na zapytanie, skanuje całą tabelę. Jeśli masz miliony rekordów – tragedia gotowa. EXPLAIN wyraźnie pokaże „Seq Scan”, co oznacza pełne czytanie tabeli.

Nieoptymalne joins

Jeśli łączysz tabele bez przemyślanej strategii lub bez odpowiednich indeksów, mogą pojawić się kosztowne „Nested Loop Joins”, które przy dużych zbiorach danych są bardzo powolne. Lepiej wtedy użyć „Hash Join” lub zoptymalizować warunki łączenia.

Brak wykorzystania indeksów

Czasami masz indeks, ale zapytanie go nie używa – czemu? Może warunki WHERE są za bardzo złożone, albo używasz funkcji na kolumnach (np. UPPER()), co blokuje wykorzystanie indeksu. EXPLAIN pokaże, że pomimo obecności indeksu, zapytanie go ignoruje.

Analiza rzeczywistych przypadków z controllingu

Zapytania do hurtowni danych finansowych

W controllingu finansowym dane najczęściej są przechowywane w hurtowniach danych – rozbudowanych, wielotabelowych strukturach zawierających szczegóły dotyczące przychodów, kosztów, budżetów, amortyzacji, a nawet cash flow. To ogromne zbiory danych, które wymagają specjalnego podejścia – szczególnie, jeśli chodzi o SQL.

Przykładowe zapytanie może dotyczyć zsumowania kosztów operacyjnych dla każdej jednostki biznesowej w danym kwartale. Bez optymalizacji, takie zapytanie może potrzebować sekund lub nawet minut na wykonanie – co przy setkach użytkowników staje się nie do przyjęcia. Plan wykonania z EXPLAIN pomaga tu znaleźć najdroższe operacje – czy to sekwencyjne skanowanie tabel, czy nieefektywne joins, albo błędnie dobrane agregacje.

Często też w hurtowniach finansowych spotykamy zapytania z ogromnymi JOINami i zagnieżdżonymi podzapytaniami. Tylko dobrze przemyślana struktura bazy i optymalizacja SQL pozwala uniknąć tzw. query hell – momentu, w którym analiza danych staje się po prostu niemożliwa.

Przykłady raportów miesięcznych i rocznych

Weźmy na przykład zapytanie generujące miesięczny raport kosztów jednostkowych, z podziałem na lokalizacje, typ kosztu i miesiąc. Taka analiza może łączyć dane z:

- tabeli

wydatki, - tabeli

konta_księgowe, - tabeli

działy, - tabeli

czas.

Bez odpowiednich indeksów, takie zapytanie potrafi zeskanować miliardy wierszy. Dzięki EXPLAIN wiemy, które z joinów są problematyczne, które filtry są nieefektywne, i gdzie można skrócić drogę do wyniku.

Jak EXPLAIN pomaga zidentyfikować wąskie gardła

EXPLAIN pozwala dokładnie zidentyfikować miejsca, w których zapytanie „dusi się” w bazie danych. Można porównać go do EKG – pokazuje, gdzie zapytanie bije mocno, a gdzie ledwie zipie. Czy skanuje całą tabelę? Czy używa odpowiedniego indeksu? Czy nie robi zbędnych sortów?

W controllingu liczy się każda sekunda – jeśli raport zysku brutto uruchamia się 30 sekund zamiast 2, analitycy marnują godziny w skali tygodnia. Dzięki analizie planów wykonania możemy w ciągu kilku minut poprawić zapytanie i zaoszczędzić całe dnie.Dodawanie i optymalizacja indeksów

Kiedy warto dodać indeks

Nie każde zapytanie wymaga indeksu, ale są sytuacje, kiedy indeks to absolutny must-have. Główne zasady są proste:

- Jeśli kolumna jest często używana w filtrach WHERE – zindeksuj ją.

- Jeśli tabela jest często łączona po danej kolumnie – rozważ indeks.

- Jeśli sortujesz lub grupujesz po danej kolumnie – indeks pomoże.

W controllingu takie kolumny to np. data_transakcji, kategoria_kosztu, dział, kod_jednostki, konto_księgowe. Warto pamiętać, że zbyt wiele indeksów może obniżyć wydajność operacji INSERT/UPDATE – dlatego najlepiej używać ich mądrze, na podstawie danych z EXPLAIN.

Typy indeksów: B-tree, wielokolumnowe, pełnotekstowe

W relacyjnych bazach danych najczęściej stosuje się:

- B-tree index – idealne dla równości i zakresów (

=,BETWEEN,>,<). - Wielokolumnowe indeksy – przydatne, gdy zapytanie filtruje lub sortuje po więcej niż jednej kolumnie.

- Indeksy pełnotekstowe – mniej popularne w controllingu, bardziej używane w dokumentacji i wyszukiwarkach tekstu.

W PostgreSQL można używać także GIN, GiST czy BRIN – przy bardzo dużych zbiorach danych mogą przynieść spektakularną poprawę.

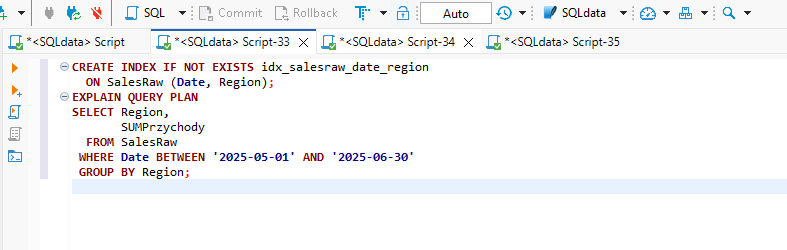

Przykłady efektywnego użycia indeksów w controllingu

Wyobraźmy sobie zapytanie:

sql

KopiujEdytujSELECT SUM(kwota)

FROM wydatki

WHERE data_transakcji BETWEEN '2024-01-01' AND '2024-01-31'

AND dział = 'Marketing';

Bez indeksu na data_transakcji i dział, zapytanie może pełzać przez całą tabelę. Dodanie indeksu:

sql

KopiujEdytujCREATE INDEX idx_wydatki_data_dzial ON wydatki (data_transakcji, dział);

pozwala skrócić czas wykonania nawet 10-krotnie.

Inny przykład: zapytanie łączące dane kosztów i przychodów na podstawie kont księgowych. Indeks na kolumnie konto_księgowe w obu tabelach zmienia wszystko – zamiast „Seq Scan” mamy „Index Scan” i wykładniczy wzrost szybkości.

Alternatywy dla indeksowania

Materialized Views

Jeśli zapytania są bardzo złożone, a dane nie zmieniają się co sekundę, warto rozważyć „Materialized Views” – czyli zapamiętane wyniki zapytań, które odświeżają się cyklicznie. To świetne rozwiązanie np. dla raportów dziennych lub miesięcznych, które nie muszą pokazywać danych w czasie rzeczywistym.

Podzapytania vs. tymczasowe tabele

W niektórych przypadkach warto zamienić zagnieżdżone podzapytania na tymczasowe tabele (TEMP TABLES). Dzięki temu można znacząco zredukować czas wykonania. Jest to szczególnie skuteczne przy zapytaniach łańcuchowych w controllingu – np. agregacja danych, potem join z tabelą słownikową i sortowanie.

Rewriting zapytań dla lepszej wydajności

Czasami najlepszym sposobem optymalizacji jest… przepisanie zapytania. Zamiast zagnieżdżonych SELECT-ów – CTE (WITH). Zamiast JOINów – EXISTS. SQL daje wiele sposobów na osiągnięcie tego samego celu, ale tylko niektóre są optymalne.

Narzędzia wspierające optymalizację SQL

SQL Profiler

SQL Profiler (np. dla SQL Server) to narzędzie monitorujące wszystkie operacje SQL w czasie rzeczywistym. Umożliwia śledzenie, które zapytania są najczęściej uruchamiane, ile czasu zajmuje ich wykonanie, i jak wpływają na zasoby serwera. W controllingu to bardzo przydatne narzędzie – pozwala zidentyfikować zapytania spowalniające generowanie raportów lub działanie dashboardów BI.

Za pomocą Profiler’a można np. wykryć zapytania, które przeciążają CPU, zużywają zbyt dużo pamięci, wykonują niepotrzebne joins. Po identyfikacji – kierunek jest prosty: EXPLAIN → optymalizacja → testy.

Database Tuning Advisor

To kolejny niezastąpiony pomocnik. Działa w systemach takich jak SQL Server i automatycznie sugeruje, jakie indeksy warto dodać, jak przekształcić zapytanie, czy też gdzie zmienić strukturę bazy danych. Idealny dla mniej doświadczonych użytkowników controllingu, którzy nie zawsze wiedzą, jak zoptymalizować SQL ręcznie.

Tuning Advisor może zaproponować np. indeks składający się z trzech kolumn albo zaproponować przekształcenie JOIN w INNER APPLY – wszystko po to, by zapytania działały szybciej.

Narzędzia open-source: pgBadger, Percona Toolkit

W środowiskach PostgreSQL i MySQL polecane są narzędzia takie jak:

- pgBadger – analizuje logi PostgreSQL i przedstawia raporty graficzne: najcięższe zapytania, czas wykonania, statystyki.

- Percona Toolkit – dla MySQL i MariaDB. Oferuje wiele funkcji, w tym analizę indeksów, monitorowanie zapytań, replikację i analizę wydajności.

To świetna alternatywa dla płatnych rozwiązań, szczególnie w mniejszych organizacjach finansowych lub w projektach, gdzie controlling działa na open-source’owej infrastrukturze.

Praktyczne techniki optymalizacji zapytań

Unikanie SELECT *** i nadmiarowych JOINów

To jedna z podstawowych zasad optymalizacji SQL: nigdy nie używaj SELECT * w raportach produkcyjnych. Każda niepotrzebna kolumna to więcej danych do przesłania i przetworzenia – to kosztuje czas i zasoby. W controllingu oznacza to wolniejsze raporty, opóźnione zestawienia i frustrację zespołu.

Równie niebezpieczne są JOINy, które dołączają dane niepotrzebne w finalnym wyniku. Jeśli dołączasz tabelę tylko po to, by użyć jednej kolumny w filtrze – może warto użyć podzapytania lub EXISTS?

Optymalizacja zaczyna się od czystości zapytania: tylko to, co potrzebne. To jak pakowanie walizki na delegację – nie zabierasz przecież całej szafy.

Optymalizacja zapytań agregujących

SUMA, ŚREDNIA, COUNT – agregacje to chleb powszedni w controllingu. Ale jeśli są źle zaprojektowane, mogą stać się gwoździem do trumny dla wydajności systemu.

Dobrą praktyką jest agregowanie danych na jak najmniejszym zbiorze – np. zamiast agregować 10 milionów rekordów, najpierw przefiltruj je do 500 tysięcy. Pomoże też stworzenie indeksów na kolumnach grupujących (GROUP BY), co może kilkukrotnie przyspieszyć wykonanie.

Zamiast:

sql

KopiujEdytujSELECT dział, SUM(kwota)

FROM wydatki

GROUP BY dział;

lepiej:

sql

KopiujEdytujSELECT dział, SUM(kwota)

FROM wydatki

WHERE rok = 2025

GROUP BY dział;

Filtrowanie przed agregacją to klucz!

Użycie LIMIT i OFFSET w raportach finansowych

Część zapytań generujących raporty zawiera funkcje LIMIT i OFFSET, szczególnie w kontekście paginacji. Używane niewłaściwie – mogą spowalniać działanie raportów.

OFFSET działa dobrze tylko na małych zbiorach. Dla dużych – przesuń logikę paginacji na poziom aplikacji lub zastosuj tzw. keyset pagination (WHERE id > X). Dzięki temu kolejne strony danych będą się ładować niemal natychmiastowo – nawet przy milionach rekordów.

Optymalizacja zapytań OLAP w controllingu

Różnice między OLTP a OLAP

OLTP (Online Transaction Processing) to systemy transakcyjne – szybkie, proste zapytania, często INSERT/UPDATE. OLAP (Online Analytical Processing) – czyli controlling – to systemy analityczne: ciężkie zapytania, grupowania, joins, agregacje, często wielogodzinne operacje.

Z tego powodu optymalizacja SQL w OLAP jest znacznie bardziej zaawansowana i wymaga podejścia strategicznego – indeksów, widoków materializowanych, partycjonowania tabel czy użycia dedykowanych narzędzi (np. Apache Druid, Snowflake, BigQuery).

Specyfika zapytań analitycznych i ich optymalizacja

W OLAP zapytania często mają strukturę:

sql

KopiujEdytujWITH dane AS (

SELECT ...

FROM ...

JOIN ...

WHERE ...

)

SELECT dział, SUM(przychód - koszt) AS EBITDA

FROM dane

GROUP BY dział;

Tutaj nie da się uciec od złożoności, ale można nią zarządzać:

- ogranicz liczbę kolumn,

- stosuj filtry jak najwcześniej,

- przemyśl joiny i ich kolejność,

- używaj CTE tylko wtedy, gdy warto (CTE potrafią być kosztowne, jeśli nie są inline’owane).

W OLAP każda sekunda się liczy – gdy dashboard BI czeka na wynik z hurtowni, cała firma czeka z decyzjami.

Automatyzacja optymalizacji zapytań

Użycie skryptów i triggerów do monitorowania wydajności

W dużych środowiskach controllingu finansowego ręczne śledzenie każdego zapytania SQL jest nierealne. Tu z pomocą przychodzą skrypty monitorujące i triggery, które automatycznie analizują czas wykonania zapytań oraz liczbę przetworzonych rekordów.

Można skonfigurować mechanizmy, które:

- zapisują statystyki najwolniejszych zapytań do dedykowanej tabeli logów,

- uruchamiają alert, jeśli zapytanie trwa dłużej niż X sekund,

- logują liczbę wierszy dotkniętych przez każde zapytanie.

To nie tylko pomaga w bieżącym monitoringu, ale też buduje historię, którą można analizować pod kątem optymalizacji w dłuższej perspektywie.

Automatyczne rekomendacje indeksów

Niektóre systemy baz danych (np. SQL Server, Azure SQL, Oracle) oferują tzw. „Index Advisor” – komponent analizujący historię zapytań i sugerujący najlepsze indeksy. Te rekomendacje bazują na rzeczywistych danych i planach wykonania, więc są bardziej trafne niż ręczne zgadywanie.

W controllingu oznacza to mniej ręcznej pracy i większą efektywność. Przykładowo – jeśli zapytania o „koszty transportu” są uruchamiane codziennie i filtrują po kolumnach kategoria_kosztu, rok, miesiąc, system może sam zaproponować indeks wielokolumnowy na tych właśnie polach.

Automatyzacja pozwala utrzymać optymalną wydajność w czasie, bez ciągłej interwencji administratorów.

Częste błędy i pułapki w optymalizacji

Zbyt duża liczba indeksów

Paradoksalnie – zbyt dużo indeksów może zaszkodzić. Każdy indeks to dodatkowy koszt podczas zapisu (INSERT, UPDATE, DELETE). W controllingu, gdzie dane często są ładowane z zewnętrznych systemów (np. ERP), nadmiar indeksów może spowolnić ETL.

Dobrą praktyką jest:

- regularny przegląd nieużywanych indeksów (np. za pomocą

pg_stat_user_indexesw PostgreSQL), - testowanie wpływu nowego indeksu na czas operacji zapisu,

- unikanie duplikatów – dwa indeksy o tej samej strukturze to marnowanie miejsca i zasobów.

Nieużywane kolumny w SELECT

Zbyt często spotykanym błędem jest zapytanie pobierające więcej danych niż potrzebne. SELECT 10 kolumn, gdy raport potrzebuje 3 – to typowy grzech. Każda dodatkowa kolumna to więcej danych do przeniesienia, więcej operacji dyskowych i wolniejsze działanie.

W controllingu – gdzie dane są często przesyłane między systemami BI a bazą – ma to duży wpływ na czas odpowiedzi interfejsu.

Nadmierna złożoność zapytań

Im bardziej skomplikowane zapytanie, tym trudniej je zoptymalizować. 10 JOINów, 5 CTE i dwie podkwerendy to przepis na problemy. Warto rozbijać zapytania na mniejsze kroki, a tam gdzie to możliwe – korzystać z tymczasowych tabel.

SQL nie zawsze premiuje „inteligentne” konstrukcje – czasami lepiej pójść drogą prostoty i przewidywalności.

Wpływ optymalizacji SQL na controlling finansowy

Przykładowe korzyści biznesowe

Optymalizacja SQL przekłada się bezpośrednio na wyniki controllingu. Szybsze raporty = szybsze decyzje. Mniej błędów = większe zaufanie do danych. Mniejsze zużycie zasobów = niższe koszty utrzymania infrastruktury.

Korzyści to m.in.:

- krótszy czas analizy cash flow i rentowności,

- możliwość uruchamiania raportów ad hoc w czasie rzeczywistym,

- lepsza jakość danych dostarczanych do zarządu i audytorów.

Krótszy czas generowania raportów

Raport EBITDA, który wcześniej działał 45 sekund, po optymalizacji skraca się do 3 sekund. Dashboard KPI, który odświeżał się co 5 minut, teraz działa w czasie rzeczywistym. To konkretne liczby, które robią wrażenie na każdym CFO.

Większa responsywność systemów BI

Narzędzia typu Power BI, Tableau, Looker – wszystkie opierają się na SQL. Gdy zapytania są zoptymalizowane, dashboardy działają szybciej, raporty się nie zawieszają, a użytkownicy mogą samodzielnie eksplorować dane.

Optymalizacja zapytań to zatem nie tylko domena IT – to kluczowy czynnik UX dla analityków finansowych.

Case study: Optymalizacja raportu EBITDA

Problem: długi czas wykonania zapytania

Firma X, średniej wielkości producent przemysłowy, miała problem z raportem EBITDA generowanym przez zespół controllingu. Zapytanie łączyło dane z pięciu tabel, w tym dane z SAP i hurtowni kosztów. Czas wykonania – ponad 2 minuty. Dla użytkowników końcowych – nieakceptowalne.

Analiza EXPLAIN i dodanie indeksu

Zespół wykonał analizę EXPLAIN – okazało się, że główne problemy to:

- brak indeksu na

konto_księgowe, - zbędne sortowanie po

dział, - JOIN do tabeli

wydatkipo kolumnie bez indeksu.

Dodano indeksy, przepisało zapytanie do formy z CTE i zastosowano filtry przed agregacją.

Ostateczne wyniki i wnioski

Czas wykonania spadł do 6 sekund. Użytkownicy zyskali responsywny raport, a controlling mógł wykonywać więcej analiz bez blokowania systemu.

Wniosek: jedno dobrze zoptymalizowane zapytanie potrafi zmienić sposób działania całej firmy.

Najlepsze praktyki i checklisty

Lista kontrolna optymalizacji zapytania

- Czy zapytanie używa tylko potrzebnych kolumn?

- Czy zastosowano odpowiednie indeksy?

- Czy EXPLAIN pokazuje Index Scan zamiast Seq Scan?

- Czy agregacje są poprzedzone filtrami?

- Czy JOINy są niezbędne i zoptymalizowane?

Regularny przegląd indeksów

Zaleca się co miesiąc:

- przeglądać indeksy nieużywane (

pg_stat_user_indexes,dm_db_index_usage_stats), - usuwać duplikaty,

- testować wpływ indeksów na INSERT/UPDATE.

Automatyczne testowanie wydajności

Za pomocą CI/CD można wbudować testy wydajności zapytań – np. skrypt uruchamiający SELECT i mierzący czas. Jeśli czas > 1 sekunda – zapytanie trafia do rewizji. Proste, skuteczne i bardzo kontrolingowe.

Podsumowanie i dalsze kroki

Zaawansowana optymalizacja SQL to jeden z najważniejszych elementów pracy controllera finansowego w erze cyfrowej. Zrozumienie EXPLAIN, umiejętne dodawanie indeksów, eliminacja bottlenecków – to fundamenty, które sprawiają, że controlling staje się nie tylko szybki, ale i precyzyjny.

Zachęcam Cię, byś już dziś uruchomił EXPLAIN dla swoich najcięższych raportów i sprawdził, czy nie da się ich przyspieszyć. To niewielki wysiłek, który może przynieść ogromne korzyści.

FAQ

1. Czy każde zapytanie wymaga indeksu?

Nie. Indeksy są kosztowne przy zapisie, dlatego powinny być dodawane tylko tam, gdzie realnie poprawiają wydajność zapytań SELECT.

2. Jak często powinienem przeglądać plany wykonania?

Raz na miesiąc lub przy każdej większej zmianie w strukturze zapytań, danych, lub schematu bazy.

3. Czy EXPLAIN działa tak samo w każdej bazie danych?

Nie. Każdy silnik ma swoją wersję EXPLAIN – np. PostgreSQL jest bardzo dokładny, MySQL uproszczony, SQL Server ma graficzną wersję.

4. Jakie narzędzia open-source polecacie do monitoringu SQL?

pgBadger (PostgreSQL), Percona Toolkit (MySQL), oraz narzędzia takie jak Zabbix czy Grafana z wtyczkami SQL.

5. Czy warto stosować cache na poziomie aplikacji?

Tak, jeśli dane nie muszą być zawsze aktualne w czasie rzeczywistym. Cache potrafi odciążyć bazę i przyspieszyć frontend.